Von Matthew Ehret / The Last American Vagabond

![]()

“Können wir Erdbeben vorhersagen? Nein. Weder das United States Geology Survey (USGS) noch andere Wissenschaftler haben jemals ein großes Erdbeben vorhergesagt. Wir wissen nicht wie, und wir erwarten auch nicht, dass wir es in absehbarer Zeit wissen werden.”

Webseite des United States Geology Survey

Am Morgen des 6. Februar 2023 wurden die Menschen in der Türkei und in Syrien von einem verheerenden Erdbeben der Stärke 7,8 heimgesucht, gefolgt von einem Nachbeben der Stärke 6,7 und einem (hoffentlich) letzten Beben der Stärke 7,5 am späten Nachmittag. Die Auswirkungen des dreifachen Bebens reichten bis tief nach Syrien hinein und zum Zeitpunkt der Niederschrift dieses Berichts wurden in der Türkei und in Syrien über 20.000 Todesopfer gezählt, hinzu kamen Zehntausende von Verletzten und eine unglaubliche Zerstörung der Infrastruktur.

![]()

Wäre da nicht die politische Vernebelung, die in den letzten Jahrzehnten alle Bereiche der Wissenschaft zum Erliegen gebracht hat, wäre dieser tragische Verlust an Menschenleben völlig vermeidbar gewesen.

![]()

Weil trotz des Geschreis der Priester der Standardmodell-Geologie, die das US Geological Survey leiten, Erdbeben tatsächlich vollständig vorhersagbar sind.

![]()

Nehmen wir den einzigartigen Fall des niederländischen Wissenschaftlers Frank Hoogerbeets, der als Vertreter des selbstfinanzierten Solar System Geometry Survey (SSGEOS) den folgenden Tweet ganze drei Tage vor der Katastrophe vom 6. Februar veröffentlichte:

![]()

Indem er über die Methode nachdachte, die er und andere gleichgesinnte Wissenschaftler innerhalb der internationalen Gemeinschaft der Prognostiker anwenden, erklärte Hoogerbeets:

![]()

“Wie ich bereits sagte … würde dies in dieser Region passieren, ähnlich wie in den Jahren 115 und 526. Diesen Erdbeben geht immer eine kritische planetarische Geometrie voraus, wie wir sie am vierten und fünften Februar hatten”.

Von welcher Art von “planetarischer Geometrie” spricht Hoogerbeets?

![]()

Es geht nicht darum, dass Hoogerbeets eine Kristallkugel benutzt, an Astrologie glaubt oder über bessere Daten verfügt als die Wissenschaftler des US Geographical Survey, sondern darum, dass er einfach ein echter Wissenschaftler ist, der nicht an dogmatische Verfahren glaubt, die sich als “Wissenschaft” tarnen, wenn sie nicht wirklich funktionieren. Seine Methode, “planetarische Geometrien” als wichtige Komponente seines Erfolgs zu betrachten, wurde in dem dreiminütigen Einführungsvideo Earthquakes and Electro Magnetic Waves (Erdbeben und elektromagnetische Wellen) dargelegt:

![]()

Es sollte auch erwähnt werden, dass dies nicht die erste erfolgreiche Vorhersage von Hoogerbeets war.

![]()

Am 2. Februar 2023 veröffentlichte SSGEOS, dass es “das Potenzial für stärkere seismische Aktivität in oder in der Nähe des violetten Bandes (das die Ostseite Südamerikas anzeigt) in 1-6 Tagen” gebe. Auf diese Warnung folgte am 5. Februar 2023 ein Erdbeben der Stärke 5,6 im chilenischen Cuiquimbo.

![]()

Am 29. Januar 2023 sagte SSGEOS eine stärkere seismische Aktivität in einem Gebiet voraus, das er auf einer Karte als Südchina und Nordindien umriss. Innerhalb eines Tages folgte ein Erdbeben der Stärke 5,8, das den Süden Xinjiangs traf.

![]()

Seit der Einrichtung von SSGEOS im Jahr 2014 haben Hoogerbeets und sein Team Hunderte von erfolgreichen Vorhersagen gemacht, die in krassem Gegensatz zu ihren Mainstream-Konkurrenten stehen, deren Einsatz für statistische Wahrscheinlichkeitstheorie und lineare Computermodellierung seit Jahrzehnten immer wieder zu katastrophalen Fehlschlägen führt.

![]()

Was Hoogerbeets von jenen Statistikern unterscheidet, die das Feld der Seismologie dominieren, ist einfach seine Betonung der elektromagnetischen, chemischen und galaktischen Eigenschaften der Erddynamik.

![]()

Im Gegensatz zu den modernen “Seismologen”, die behaupten, dass alle der absurden “elastischen Rückpralltheorie” folgen müssen, die davon ausgeht, dass die einzige Ursache für Erdbeben in tektonischen Platten und Gravitationskräften zu suchen ist, konzentrieren sich die Wissenschaftler, die auf diesem umstrittenen Gebiet erfolgreiche Vorhersagen machen, stattdessen auf die elektromagnetischen Eigenschaften der Erde und des weiteren Sonnensystems (und der Galaxie), die die Erde umgeben.

![]()

“Auf der Grundlage unserer Forschung scheint es, dass die Gravitation nicht für größere Erdbeben zum Zeitpunkt der kritischen planetarischen und lunaren Geometrie verantwortlich ist. Die wahrscheinlichste Kraft, die zum Zeitpunkt der kritischen Geometrie auf die Erdkruste wirkt, ist die elektromagnetische. Dies könnte auch die Blitze in der Erdatmosphäre vor größeren Erdbeben erklären, die das Ergebnis einer atmosphärischen Kraft sein könnten, die durch elektromagnetische Ladung aus der kritischen Geometrie zwischen Himmelskörpern im Sonnensystem hervorgerufen wird.”

In Hoogerbeets’ Schriften und Lehrvideos erklärt der niederländische Meteorologe, dass der Raum zwischen den Planeten und Sternen nicht leer ist, sondern von subtilen, aber wirksamen Magnetfeldern und elektrischen Strömen durchdrungen wird, die in die einzelnen Planeten, Monde und die Sonne einfließen. Das Analogon, das für diesen Prozess verwendet wird, ist kein Computermodell mit abstrakten Vorstellungen von “Gravitationskräften, die an Objekten im leeren Raum ziehen”, wie es so oft der Fall ist, sondern vielmehr ein elektrischer Prozess, bei dem die Sonne als eine Art Dynamo und die Planeten als Antennen fungieren, die gleichzeitig Signale entsprechend bestimmter Wellenlängen empfangen, umwandeln und aussenden.

![]()

Hoogerbeets zitiert den RCA-Funkingenieur John Nelson, der in den 1960er Jahren 1500 atmosphärische Bedingungen mit einer Genauigkeit von 95,2% vorhersagte:

![]()

“Die Ähnlichkeit zwischen einem elektrischen Generator mit seinen sorgfältig platzierten Magneten und der Sonne mit ihren sich ständig verändernden Planeten ist verblüffend. Im Generator sind die Magnete fest angebracht und erzeugen einen konstanten elektrischen Strom. Wenn wir die Planeten als Magnete und die Sonne als Anker betrachten, haben wir eine große Ähnlichkeit mit dem Generator.”

Diese Eigenschaft der Planeten und Monde im Sonnensystem wurde von den Satelliten Voyager und Cassini bestätigt, die spezifische EM-Wellen aufzeichneten, die von allen Planeten ausgestrahlt wurden, von Radiowellen über Mikrowellen bis hin zu Infrarotwellen und sogar kleineren Wellenlängen.

![]()

Dies wurde auch von Dr. Michael Clarage, dem leitenden Wissenschaftler des Safire-Projekts, in seinem kürzlich erschienenen 16-minütigen Video “Function in the Cosmos” sehr schön dargestellt:

![]()

Zugegeben, die Ursachen für die elektromagnetische Emission/Absorption zwischen den Planeten sind nicht bekannt. Ebenfalls nicht vollständig verstanden ist, wie diese Emissionen die Aktivität sowohl in der Atmosphäre als auch in der Ionosphäre der Erde beeinflussen – ganz zu schweigen von der Erdkruste, dem Erdmantel und dem Erdkern. Der Mensch hat ja nur 16 km durch die 60 km dicke Kruste gebohrt und hat keine direkte Kenntnis des Erdmantels oder des Erdkerns.

![]()

Trotz unserer Unkenntnis von so vielem wissen wir einiges über die Magnetfelder und Resonanzen in unserem Sonnensystem, und allein die Anerkennung dieser Realität und ihres Einflusses auf das Geschehen auf der Erde ist schon der erste Schritt zu einer Entdeckung… was mehr ist, als man von den Wächtern der Standardtheorie sagen kann, die versuchen, neue Entdeckungen zu verhindern.

![]()

Grundlegende Vorläufer für eine Wissenschaft der Erdbebenprognose

Einer der Faktoren, die in der Wissenschaft der Erdbebenprognose eine immer größere Rolle zu spielen scheinen, sind die chemischen Absonderungen von Elementen wie Radon aus dem Grundwasser in der Nähe von Erdbebenherden Tage und Stunden vor und nach einem Ereignis.

![]()

Was die Freisetzung von Radon verursacht, ist noch unbekannt, doch genau damit beschäftigte sich der Techniker Gianpalo Giuliani, als er 2009 ein Erdbeben vorhersagte, das wenige Tage später die italienische Stadt l’Aqila erschütterte.

![]()

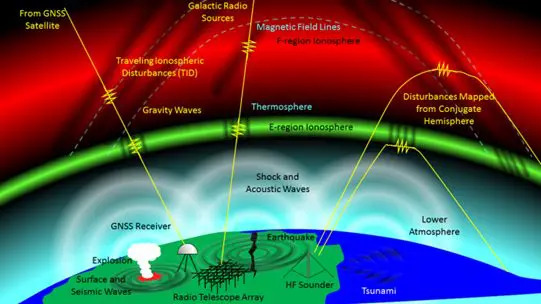

Eine weitere besonders wichtige Variable bei der Erdbebenprognose ist das Verhalten der großen Schicht aus ionisiertem Plasma, die die Erde umgibt und sich von 65 km Höhe bis 965 km über der Oberfläche erstreckt. Diese Zone wird Ionosphäre genannt und ist voller Elektronen und elektrisch geladener Atome und Moleküle, die von den konstanten Strahlungsflüssen (hauptsächlich UV- und Röntgenstrahlung) der Sonne beeinflusst werden, aber auch von den elektromagnetischen Impulsen anderer Planeten innerhalb des elektrischen Schaltkreises, der unser Sonnensystem darstellt.

![]()

Wie Sergey Pulinets in seinem Artikel “Principles of Organizing Earth Quake Forecasting based on Multi Parameter Sensors” (“Grundlagen der Organisation der Erdbebenprognose auf der Basis von Multi-Parameter-Sensoren”) vom 16. Oktober 2020 beschreibt:

![]()

“Im Falle von ionosphärischen Vorläufern manifestiert sich der Vorläufer … in Form einer starken positiven Variation der Elektronenkonzentration über der Erdbeben-Vorbereitungszone.”

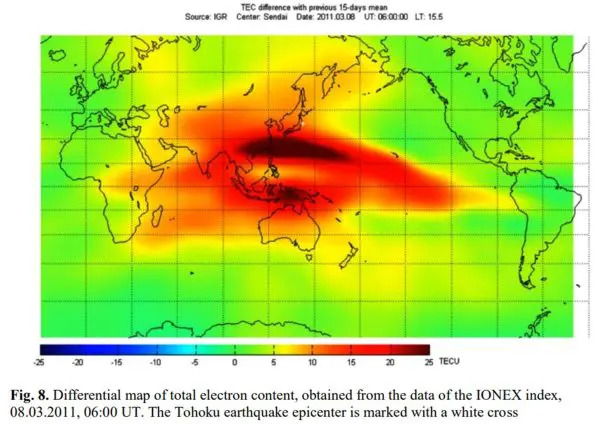

Im relativ aktuellen Fall des tödlichen Erdbebens der Stärke 9,1, das Japan erschütterte, führte es zu dem Tsunami, der im März 2011 auf die japanische Küste prallte, über 20.000 Menschen tötete und Schäden in Höhe von 38 Milliarden Dollar hinterließ. Wie in der nachstehenden Grafik zu sehen ist, wäre diese Tragödie durchaus vorhersehbar gewesen, wenn man sich die Spitze der Elektronendichte in der Ionosphäre über dem Epizentrum angesehen hätte, die elf Tage vor der Katastrophe einsetzte, wie eine forensische Analyse des chinesischen Forschers Fuying Zhu am Wuhan-Institut für Seismologie im August 2011 zeigte.

![]()

Eine weitere Studie des japanischen Seismologen Kosuke Heki bestätigte nicht nur die Ergebnisse von Zhu, sondern ging noch weiter zurück und fand dieselben Elektronenflüsse in der Ionosphäre Tage vor dem Erdbeben der Stärke 8,8 in Chile im Jahr 2010, bei dem 524 Menschen starben, und vor dem Erdbeben der Stärke 8,3 in Hokkaido im Jahr 1994.

![]()

2011 begann ein Forscherteam mit der Auswertung der Daten des DEMETER-Satelliten, des modernsten Satelliten zur Aufspürung von Erdbebenvorläufern aus dem Weltraum, der zwischen 2004 und 2010 in Betrieb war. Die Forscher suchten nach elektromagnetischen Anomalien, die es der Regierung Haitis ermöglicht hätten, das Erdbeben der Stärke 7,0, das am 12. Januar 2010 250.000 Menschen das Leben kostete, rechtzeitig vorherzusehen.

![]()

Das Team veröffentlichte eine Abhandlung über seine Ergebnisse, in der es schrieb:

![]()

“Einen Tag (11. Januar 2010) vor dem Erdbeben gibt es eine signifikante Erhöhung der Elektronendichte und der Elektronentemperatur in der Nähe des Epizentrums… Die statistische Verarbeitung der DEMETER-Daten zeigt, dass Satellitendaten eine wichtige Rolle bei der Untersuchung von Vorläufererscheinungen im Zusammenhang mit Erdbeben spielen können.”

Wie in den meisten Fällen, in denen es um elektromagnetische/chemische Vorläufer geht, hatte das Projekt kein Budget, um Personal für die Echtzeitanalyse der Daten zu bezahlen, und so wurde auch nichts gesehen oder getan.

![]()

Zu den früheren Arbeiten über erfolgreiche Vorhersagen, die die vermeintlichen Regeln der “Theorie des elastischen Rückpralls” auf den Kopf stellen, gehört die Arbeit des Elektroingenieurs Dr. Antony Frasier-Smith aus Stanford, der ein Erdbeben der Stärke 7,1 des Loma Prieta in der San Francisco Bay Area in Kalifornien zwei Wochen vor dem Beben am 17. Oktober 1989 genau vorhersagte. Dr. Frasier-Smith hatte Sensoren in der Nähe des späteren Epizentrums des Bebens installiert, die 14 Tage vor der Erschütterung eine 20-fache Erhöhung der ultra-niederfrequenten (ULF) Radiowellen feststellten, die drei Stunden vor dem Ereignis auf eine 60-fache Erhöhung über dem Durchschnitt anstieg.

![]()

Ähnliche Vorläufer wurden von Forschern in Armenien vor einem Erdbeben der Stärke 6,9 im Dezember 1988 und wiederum einige Tage vor einem Erdbeben der Stärke 8,0 in Guam im August 1993 beobachtet.

![]()

Angeregt durch Dr. Fraser-Smiths Vorhersage von 1989 in Kalifornien gründete ein Wissenschaftler namens Tom Bleier im Jahr 2000 im kalifornischen Palo Alto das Unternehmen “Quake Finder”, das derzeit ein Netz von 125 Magnetometern rund um die San-Andreas-Verwerfung überwacht, die die massive, erdbebendichte Zone bildet, die als “Ring of Fire” bezeichnet wird und sich von Japan über Russland, Alaska und die Westküste Amerikas erstreckt. In Zusammenarbeit mit einer Gruppe namens “Stellar Solutions” hat Bleiers Team 20 Jahre lang Beweise für ähnliche Vorläufer gesammelt, die vor Dutzenden von kleinen bis mittleren Erdbeben aufgetreten sind.

![]()

Ein anderes Forscherteam griff die Erkenntnisse von Frasier-Smith auf und untersuchte das schwere Erdbeben vom 22. September 1999 in Taiwan, das 2500 Todesopfer und Schäden in Höhe von 300 Milliarden Dollar zur Folge hatte. Dieses Team entdeckte nicht nur die ULF-Signale Tage im Voraus, sondern fand auch mehrere Anknüpfungspunkte zu den Sonnenwindströmen, die diese ultraniedrigen Radioemissionen begleiteten, die aus mindestens 8 km Tiefe unter der Erdoberfläche kamen.

![]()

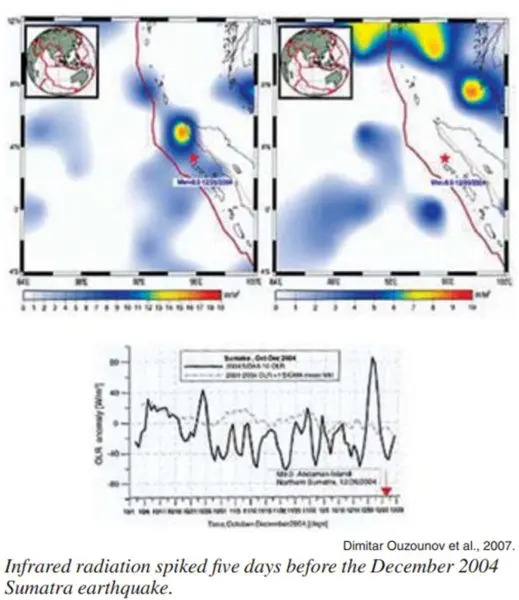

Ein weiterer elektromagnetischer Vorläufer, der sich bewährt hat, sind Infrarot-Emissionen, die ebenfalls vor großen Erdbeben auftauchen. Dies wurde vom Erdbeobachtungssatelliten Terra der NASA am 21. Januar 2001 beobachtet, der solche “thermischen Anomalien” im indischen Gujarat fünf Tage vor einem Erdbeben der Stärke 7,7 aufzeichnete, bei dem mehr als 20.000 Zivilisten getötet und 350.000 Gebäude zerstört wurden. Diese Anomalie verschwand unmittelbar nach dem Ende des Bebens.

![]()

Wie in der Abbildung unten zu sehen ist, ging dem Erdbeben/Tsunami der Stärke 9,3, das am 26. Dezember 2004 auf der indonesischen Insel Sumatra 228.000 Menschen tötete, eine anomale Erhöhung der Infrarotstrahlung fünf volle Tage vor der Tragödie voraus. Leider werden diese Vorläufer aufgrund der Ablehnung dieses gesamten Wissenschaftsbereichs als “ketzerische Randerscheinung” entweder nicht beachtet oder sie wurden erst NACH der Katastrophe entdeckt, da keine finanziellen Mittel für die Einrichtungen zur Verfügung gestellt wurden, die für die Auswertung der Daten in Echtzeit erforderlich sind.

![]()

Es gibt noch viele weitere Fälle von Erdbebenprognosen, die man hätte anführen können, bei denen alle oben genannten Parameter und mehr berücksichtigt werden.

![]()

Keplersche Wurzeln der modernen Vorhersage

Es ist wichtig, sich vor Augen zu halten, dass es sich hierbei nicht um ein neues oder “randständiges” Gebiet handelt, das in der jüngeren Geschichte entstanden ist, sondern buchstäblich Jahrtausende zurückreicht. Der vielleicht früheste Hinweis darauf, dass planetarische Geometrien und Harmonien eine direkte Rolle für die materiellen Bedingungen der Natur auf der Erde spielen, stammt aus dem Dialog Timaios von Platon aus dem Jahr 360 vor Christus.

![]()

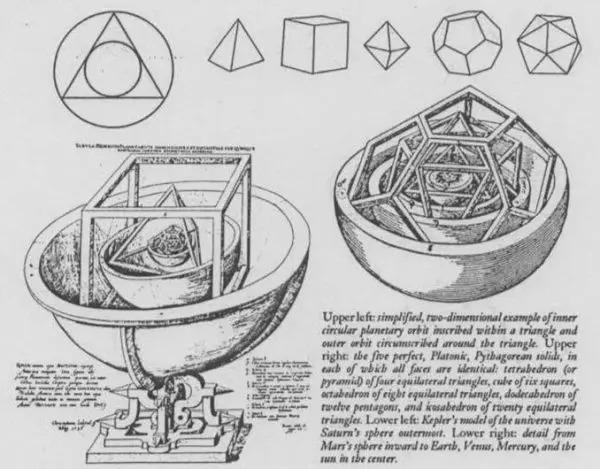

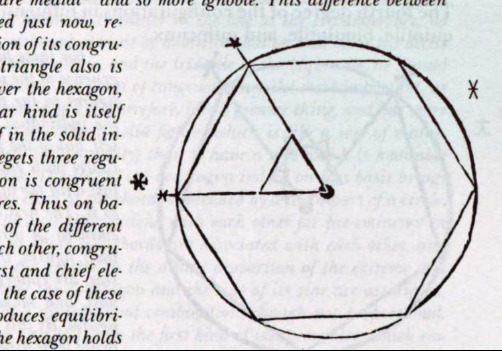

Während die pythagoreische Lehre von der Harmonie der Sphären und dem Leben der Menschen noch zwei Jahrtausende nach der Niederschrift des Timaios im Bereich der Philosophie verblieb, war es der Naturwissenschaftler Johannes Kepler, der mit seinem Mysterium Cosmographicum (1594), gefolgt von seiner Neuen Astronomie (1609) und gipfelnd in seinen Harmonien der Welt (1619), erstmals eine wirkliche Wissenschaft der Astrophysik und der planetarischen Vorhersage etablierte.

![]()

In diesem letzten Werk vollendete Kepler 30 Jahre Forschung über die pythagoreische Hypothese und formte sein berühmtes drittes Gesetz (auch bekannt als harmonisches Gesetz) der Planetenbewegung.

![]()

In Buch 4, Kapitel 7 der “Harmonien der Welt”, schreibt Kepler:

![]()

“Die Ansicht, dass es eine Seele des ganzen Universums gibt, die die Bewegungen der Sterne, die Erzeugung der Elemente, die Erhaltung der Lebewesen und Pflanzen und schließlich das gegenseitige Miteinander der Dinge oben und unten lenkt, wird von Timeaus von Locri in Platon gegenüber den pythagoreischen Überzeugungen verteidigt… ein Christ kann leicht durch den platonischen Verstand, Gott den Schöpfer und durch die Seele, die Natur der Dinge verstehen” [S. 358]

Kepler arbeitete sich durch mehrere Kapitel, in denen er die planetarischen und lunaren Geometrien (die er “Aspekte” nannte) skizzierte, die mit visuellen Harmonien in Form von archetypischen Winkeln übereinstimmen, die aus elementaren Polygonen erzeugt werden. Zu diesen elementaren Geometrien gehören unter anderem Dreiecke, Quadrate, Fünfecke, Sechsecke und Achtecke sowie die aus diesen Formen entstehenden Innenwinkel. In Buch drei seiner Harmonien hat Kepler eine Reihe von Winkeln beschrieben, die bestimmte quantisierte Zustände definieren, indem er die Beziehung der Erde zu verschiedenen Planeten, dem Mond und der Sonne nutzt.

![]()

Kepler war kein Numerologe und erkannte, dass Zahlen keine in sich geschlossenen Ursachen sind, sondern vielmehr die Wirkung jener archetypischen Formen, die die gesamte physikalische Raumzeit durchdringen. So würden beispielsweise Zahlen wie 3, 4, 5, 6, 8 durch die elementaren Formen (Dreieck, Quadrat, Fünfeck, Sechseck, Achteck) ausgedrückt, die dann zu den fünf platonischen Körpern und den 13 archimedischen Polyedern kombiniert werden können.

![]()

Ineinander verschachtelt ergeben diese platonischen Körper eine Reihe von Proportionen, die Kepler in seiner Neuen Astronomie1 als Leitfaden für seine 30 Jahre währende Suche nach den Ursachen für die Position der Planeten um die Sonne nutzte, von der er auch annahm, dass sie von einer elektrischen Flüssigkeit bewegt wird.

![]()

Die in den Elementarformen enthaltenen Innenwinkel werden ebenfalls als Eigenschaften von Qualitäten und nicht als eigenständige Größen behandelt. Zum Beispiel: Quadrate erzeugen Innenwinkel von 90, während Dreiecke Innenwinkel von 60 und 120 Grad aufweisen. Fünfecke erzeugen Innenwinkel von 135 und 72 Grad, während Sechsecke Innenwinkel von 120 und 60 Grad erzeugen usw.

![]()

In seinem Werk “Harmonien der Welt” demonstriert Kepler die musikalischen Proportionen dieser Zahlen als Funktionen der Resonanz/Konsonanzen und zeigt ein Modell des Sonnensystems, das auf den wohltemperierten Tonleitern mit Dur- und Moll-Tonarten aufbaut.

![]()

Im vierten Buch der Harmonien bricht Kepler mit den Astrologen und Statistikern, die die “Standardmodelle” seiner Zeit beherrschten, indem er verschiedene nachweisbare Wetterphänomene beschreibt, die mit diesen “Aspekten” übereinstimmen:

![]()

“Ich wurde dazu … nur und ausschließlich durch die Beobachtung des Wetters und das Studium der Aspekte, durch die es angeregt wird, bewegt. Denn ich sah, dass der Zustand der Atmosphäre mit großer Beständigkeit immer dann gestört war, wenn die Planeten entweder in Konjunktion standen oder in den Aspekten konfiguriert waren, von denen die Astrologen gemeinhin sprechen. Ich sah, dass die Atmosphäre im Allgemeinen ruhig war, wenn nur wenige oder keine Aspekte auftraten oder wenn sie schnell abgeschlossen oder beendet wurden. Ich war in der Tat der Meinung, dass diese Angelegenheit nicht so leichtfertig betrachtet werden sollte, wie es die gemeine Herde der Prognostiker gewöhnlich tut.”

Später erörtert Kepler verschiedene Wetterphänomene und deren Zusammenhang mit verschiedenen geometrischen Konfigurationen des Sonnensystems:

![]()

“Ich habe die beständige Erfahrung berücksichtigt, wobei ich mich nicht auf Schnee im Besonderen oder Winde oder Donner und die anderen Dinge, die Astrologen gewöhnlich vorhersagen, konzentrierte, sondern allgemein beobachtete, dass der Zustand der Luft auf die eine oder andere Weise gestört war, wenn es Aspekte gab, zum Beispiel wenn Mars und Jupiter in Konjunktion standen und friedlich waren oder wenn es keine [Konjunktionen] gab.”

Gauß-Weber – Wegbereiter des elektrischen Modells von Atom und Universum

Später entwickelten die deutschen Wissenschaftler Carl Gauß (1777-1855) und Alexander von Humboldt (1769-1859) das Keplersche Modell eines Universums der Harmonie weiter, indem sie ein internationales wissenschaftliches Programm zur Kartierung des die Welt prägenden unsichtbaren Magnetfelds leiteten, das 1838 abgeschlossen wurde.

![]()

In Gleismeiers und Tsurutanis brillanter Studie “Carl Friedrich Gauß – General Theory of Terrestrial Magnetism” von 2014 schreiben die Autoren:

![]()

“Wie Gauß in einem Brief an seinen Freund Wilhelm Olbers (1781-1862) schreibt, interessierte er sich bereits 1803 für das Erdmagnetfeld. Dieses Interesse wurde durch die Begegnung mit Baron Alexander von Humboldt (1769-1859) und Wilhelm Weber (1804-1891) in Berlin im Jahr 1828 stark angeregt. Nach 1831 war Wilhelm Weber sein wichtigster Mitarbeiter. Angeregt durch Alexander von Humboldt erkannten Gauß und Weber, dass Magnetfeldmessungen gleichzeitig und weltweit mit standardisierten Instrumenten durchgeführt werden mussten. Dieses Forschungsprogramm führte 1836 zur Gründung des Göttinger Magnetischen Vereins, einer Organisation ohne große formale Struktur, die sich lediglich der Organisation von Magnetfeldmessungen in der ganzen Welt widmete.”

Gauß war auch ein Prognostiker ersten Ranges, der 1801 als erster die Position des Asteroiden Ceres entdeckte und damit eine 200 Jahre zuvor von Kepler gemachte Vorhersage bestätigte, wonach die Lücke zwischen Mars und Saturn zwangsläufig einen Planeten enthalten würde (in diesem Fall scheint der Asteroidengürtel entweder ein Überbleibsel eines früheren Planeten oder das Material zu sein, aus dem eines Tages ein Planet entstehen könnte).

![]()

Gauß war auch der erste Wissenschaftler, der die Notwendigkeit einer Schicht geladener elektrischer Ströme über der Stratosphäre erkannte, um die Funksignale, die die Erdoberfläche durchqueren, einzudämmen, was durch die Entdeckung der Ionosphäre im Jahr 1929 bestätigt wurde.

![]()

Es war auch Gauß’ enger Freund und Mitarbeiter Wilhelm Weber, der die Keplersche Hypothese von den harmonischen Beziehungen, die die Frequenzen des Raums in den Bereich des Mikrouniversums verlagern, aufstellte. In den 1850er Jahren war Weber der erste Wissenschaftler, dem es gelang, die genaue Entfernung eines Elektrons zu messen, das die Bahn eines Atomkerns umkreist (ohne das Elektron oder den Atomkern zu sehen).

![]()

Weder Weber noch Max Planck, der später die von Weber hinterlassene Fackel übernahm, sahen eine Spaltung zwischen dem Makrouniversum im Großen und dem Mikrouniversum im Kleinen. Für diese Wissenschaftler waren die Schlüssel, die in einem Bereich entdeckt wurden, auch wertvoll, um die Türen des anderen Bereichs zu öffnen.

![]()

Max Planck setzt sich für die Wahrheit ein

Es ist daher keine kleine Ironie, dass Plancks Erfolg bei der Gründung einer neuen Wissenschaft in der Quantenwelt durch sein Engagement für Keplers Methode motiviert war, die “die gewöhnliche Herde von Prognostikern” des 17. Jahrhunderts übertrumpfte.

![]()

In seinem Buch “Where is Science Going?” (1932) warnte Planck vor der Korrumpierung der Wissenschaft und der Prognosen durch die Ausbreitung der Statistiker und Formalisten, denen es an kreativer Flexibilität und Wahrheitsliebe fehlte, um den Schwung neuer Entdeckungen fortzusetzen, den die großen Denker von Plancks Generation ausgelöst hatten. Der alte Musiker/Wissenschaftler stellte Johannes Kepler seinem Zeitgenossen Tycho Brahe gegenüber, die beide Zugang zu denselben Daten hatten, aber nur einer hatte den Funken der Wahrheitsliebe, der die Schaffung einer neuen Physik einleitete. Max Planck schrieb:

![]()

“Kepler ist ein großartiges Beispiel für das, was ich gesagt habe. Er war immer hart im Nehmen. Er musste eine Enttäuschung nach der anderen erleiden und sogar beim Reichstag in Regensburg um die Auszahlung seines rückständigen Gehalts betteln. Er musste die Qualen ertragen, seine eigene Mutter gegen eine öffentliche Anklage wegen Hexerei verteidigen zu müssen. Aber wenn man sein Leben studiert, kann man erkennen, dass das, was ihn so energisch, unermüdlich und produktiv gemacht hat, der tiefe Glaube war, den er an seine eigene Wissenschaft hatte – nicht der Glaube, dass er schließlich zu einer arithmetischen Synthese seiner astronomischen Beobachtungen kommen könnte, sondern vielmehr der tiefe Glaube an die Existenz eines bestimmten Plans hinter der gesamten Schöpfung. Gerade weil er an diesen Plan glaubte, empfand er seine Arbeit als lohnenswert, und auch dadurch, dass er nie zuließ, dass sein Glaube erlahmte, belebte und erhellte seine Arbeit sein tristes Leben. Vergleichen Sie ihn mit Tycho de Brahe. Brahe hatte das gleiche Material unter seinen Händen wie Kepler und sogar bessere Möglichkeiten, aber er blieb nur ein Forscher, weil er nicht den gleichen Glauben an die Existenz der ewigen Gesetze der Schöpfung hatte. Brahe blieb nur ein Forscher, doch Kepler war der Schöpfer der neuen Astronomie.”

Die Statistiker würfeln mit der Wahrheit

Auch wenn es heute unterschätzt wird: Als Max Planck diese Worte inmitten des Aufstiegs eines neuen technisch-feudalen Systems des Faschismus in seiner Heimat Deutschland sagte, wurde ein erbitterter Kampf darüber geführt, in welche Richtung sich die Wissenschaft im 20. und 21. Jahrhundert entwickeln würde.

![]()

Auf der einen Seite standen Planck, Einstein, Madame Curie und andere große Wissenschaftler, die tatsächlich revolutionäre Entdeckungen hinsichtlich des Universums machten, und auf der anderen Seite standen die mathematischen Statistiker, angeführt von der “Kopenhagener Schule” von Niels Bohr, Max Heisenberg und Wolfgang Pauli. Diese letztgenannte Schule von Wahrscheinlichkeitstheoretikern forderte zu Recht, dass eine neue Wissenschaft benötigt wurde, da im Bereich der Quantenphysik anomale Daten auftauchten und neue Studien über die Tiefen des Weltraums durchgeführt wurden, die mit dem “klassischen Modell” der Newtonschen Wissenschaft nicht erklärt werden konnten.

![]()

Die Tatsache, dass diese neue Schule der Statistiker nie etwas entdeckt hat, hinderte sie nicht daran, sich 1927 als Sieger der Solvay-Konferenz zu bezeichnen. Im Zuge dieser Schlacht wurden bahnbrechende Wissenschaftler wie Max Planck, Albert Einstein, Mendelejew und Marie Curie in dieselbe Kategorie wie die starren “klassischen” Positivisten der Newtonschen Sekte (darunter Ernst Mach, Bertrand Russell, Rudolph Clausius und David Hilbert) eingeordnet, die forderten, dass die einzige im Bereich der Wissenschaft akzeptable Definition von “Wahrheit” mathematische Perfektion sein müsse.

![]()

Diesen anti-kreativen Positivisten zufolge musste, WENN bewiesen werden konnte, dass mathematische Perfektion ein unmögliches Ideal war, die WAHRHEIT SELBST als eine vermutete Existenz abgelehnt werden.

![]()

Indem sie alle Wissenschaftler, die an die Wahrheit glaubten, als “Positivisten” bezeichneten, wurde ein Strohmann geschaffen, auf den die jungen Kopenhagener Statistiker aufsprangen. Da das Universum nachweislich durch Nichtlinearität und Elemente der Ungewissheit geprägt ist (wie Kurt Gödels berühmter Beweis aus dem Jahr 1932 beweist), die die Möglichkeit einer absoluten mathematischen Wahrheit verneinen, wurde behauptet, dass nur die Wissenschaft des “Würfelns” (auch bekannt als statistische Wahrscheinlichkeit) von Wissenschaftlern zugelassen werden sollte, die die Realität experimentell erforschen wollten – sei es in der atomaren Welt oder sogar im Makrokosmos. In diesem Zusammenhang entstand Einsteins berühmte Aussage gegenüber Niels Bohr, dass “Gott nicht mit dem Universum würfelt”.

![]()

In dieser Perversion der Wissenschaft wurden Zufall und Ungewissheit zu vermeintlichen “Gesetzen” im Bereich der Quantenwelt im Kleinen, während ein starrer mechanistischer Determinismus zum vorherrschenden Gesetz des Makrokosmos im Großen wurde. Es dauerte nicht lange, bis diese gegensätzlichen Impulse zu etwas zusammengefügt wurden, das man “Standardmodell-Kosmologie” nennt und das während des Kalten Krieges zu einer seelenlosen, toten Begleiterscheinung der “Standardmodell-Quantenmechanik” wurde.

![]()

Und im Wahnsinn der Schattenwelt der Lügen, die der Kalte Krieg war, verdrängte die Angst vor der nuklearen Vernichtung zunehmend die Wahrheitsliebe in der Wissenschaft, und die grenzenlosen finanziellen Ressourcen des monströsen militärisch-industriellen Komplexes absorbierten wissenschaftliche Spitzenleistungen in die geheime Welt der schwarzen Kassen und der Spionage, die nichts mit dem Nutzen für den zivilen Sektor oder dem universellen Wissen im Allgemeinen zu tun hatten. Wissenschaftler, die sich der neuen Normalität nicht anpassten, wurden zunehmend aus dem wissenschaftlichen Establishment verdrängt, während eine neue Generation kognitiv behinderter Wissenschaftler auf den Plan trat, deren giftiger Irrationalismus nichts unberührt ließ.

![]()

Der Krebs metastasiert: Infektion von Wirtschaft, Ökologie und Geologie

Plötzlich wurde den Wissenschaftlern befohlen, die deterministischen Regeln eines Universums zu akzeptieren, das angeblich vor genau 13,7 Milliarden Jahren aus dem Nichts entstanden war und in einer linearen Extrapolation in die Zukunft einen langsamen Hitzetod sterben würde. Während dieser fatalistische Determinismus von oben nach unten durchgesetzt wurde, setzte man von unten nach oben einen fatalistischen Indeterminismus durch, bei dem die Wissenschaftler akzeptieren mussten, dass nichts über die spezifischen Prinzipien bekannt ist, die die Existenz von Protonen, Elektronen oder anderem subatomaren Verhalten bestimmen. Man nahm an, dass jedes System im Universum – von Organismen über die menschliche Wirtschaft bis hin zu Galaxien und Sonnensystemen – sowohl starr geschlossen und deterministisch als auch zufällig, fließend und irrational ist.

![]()

Dieser widersprüchliche Dualismus, der wie ein trojanisches Pferd wirkt, hat nicht nur die Entdeckungen in der Atomwissenschaft zum Scheitern gebracht (die Fusionsenergie wird zunehmend als “unmöglicher Traum, der noch 30 Jahre entfernt ist” bezeichnet), sondern auch in der politischen Ökonomie und der Klimawissenschaft.

![]()

In der Wirtschaft wurde dieser Dualismus mit der Freigabe des US-Dollars auf den globalen Spekulationsmärkten nach 1971 entfesselt, als der westlichen Welt ein neuer Kult der Konsumgesellschaft aufgezwungen wurde. In dieser neuen Ära, bekannt als “Globalisierung”, wurde die Wirtschaft als hedonistisches Streben nach Vergnügen definiert, das von atomisierten Verbrauchern angetrieben wird, die mit Gaspartikeln verglichen werden, die stochastisch in einer Spraydose umherfliegen. Das Makrosystem (auch bekannt als Spraydose), in dem sich die “Märkte” befanden, wurde zunehmend von einer neuen technokratischen Klasse von “wissenschaftlichen Ingenieuren” geformt, die der Menschheit einen geschlossenen Systemdeterminismus aufzwingen wollten, um die “Wahrnehmung” von Freiheit zu maximieren, ohne dass diese tatsächlich gegeben war.

![]()

Den Prognostikern in diesem neuen surrealen Wunderland wurde gesagt, dass sie mit Hilfe von Wahrscheinlichkeitsfunktionen gegenwärtige Trends in die Zukunft extrapolieren können, aber sie durften nicht über die Randbedingungen nachdenken, die die unsichtbaren (wenn auch realen) Zwänge formen, die eben jene Volkswirtschaften prägen, die sie beeinflussen wollten.

![]()

In der Klimawissenschaft wurden Computermodelle einem Bereich aufgezwungen, der einst die Sonne, schwankende Magnetfelder, kosmische Strahlung und die weitere galaktische Umgebung berücksichtigte. Anstatt darüber nachzudenken, dass Faktoren wie Sonnenwind, Magnetfelder und kosmische Strahlung das Erdklima bestimmen, sah sich die neue Generation von Klimawissenschaftlern, die in den 1970er Jahren und darüber hinaus an den Computermodellen des Club of Rome geschult wurden, zunehmend durch die Annahme dualistischer Absurditäten mental beeinträchtigt.

![]()

Zu diesen Absurditäten gehörte vor allem die Annahme, dass man zwar kurzfristige Wetterentwicklungen nicht vorhersagen könne (jenseits statistischer Wahrscheinlichkeitsfunktionen), dass es aber absolut sicher sei, dass sich der Globus innerhalb eines Jahrhunderts zu einem neuen Schmelzofen aufheizen würde.

![]()

In den geologischen Wissenschaften sah es nicht viel besser aus.

![]()

Während echte Wissenschaftler in den 1930er bis 1960er Jahren bahnbrechende Entdeckungen in der Erdbebenforschung machten, indem sie die magnetischen und planetarischen/solaren Ausrichtungen des Sonnensystems beobachteten, setzte sich der falsche Dualismus erneut durch, als die neue Ära der Computermodellierung auf den Plan trat.

![]()

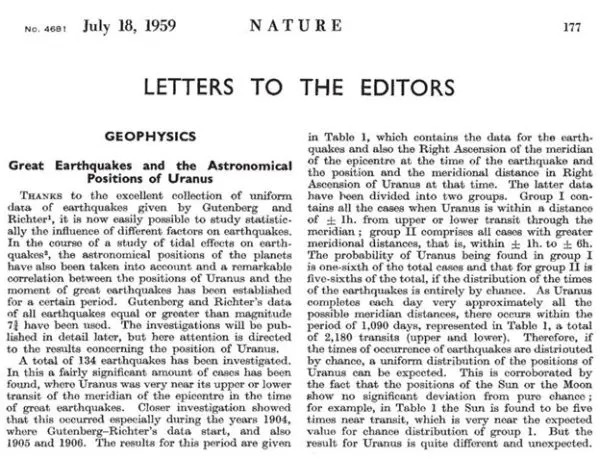

Vergleichen Sie den Artikel aus der Ausgabe des Magazins Nature vom 18. Juli 1959, in dem die neuen Erkenntnisse der Erdbebenvorhersage vorgestellt werden, mit dem modernen Evangelium des United States Geographical Survey (das die Maßstäbe für alle “akzeptablen Bildungspraktiken” im transatlantischen Raum setzt):

![]()

Konzepte, wie sie 1959 in der Zeitschrift Nature veröffentlicht wurden, sind im Laufe der Jahre immer mehr verboten worden, bis zu dem Punkt, an dem die offizielle Webseite des US Geological Survey auf die Frage, ob Erdbeben vorhergesagt werden können, die folgende Antwort gibt:

![]()

“Nein. Weder das USGS noch andere Wissenschaftler haben jemals ein großes Erdbeben vorhergesagt. Wir wissen nicht wie, und wir erwarten auch nicht, dass wir es in absehbarer Zeit wissen werden. Die USGS-Wissenschaftler können nur die Wahrscheinlichkeit berechnen, dass sich in einem bestimmten Gebiet innerhalb einer bestimmten Anzahl von Jahren ein starkes Erdbeben ereignet. Eine Erdbebenprognose muss 3 Elemente definieren: 1) das Datum und die Uhrzeit, 2) den Ort und 3) die Stärke.”

Wenn man nicht in der Lage ist, die unmöglichen Standards zu erfüllen, die von den Priestern des USGS aufgestellt wurden (die mathematisch PERFEKTE Ergebnisse bei der Vorhersage des exakten Datums und der Uhrzeit, des exakten Ortes und der exakten Stärke eines Erdbebens verlangen), wenn es auch nur eine kleine Abweichung von der mathematischen Perfektion zwischen Vorhersage und empirischem Ergebnis gibt, dann wird behauptet, dass keine Vorhersage gemacht wurde. Die Ironie liegt natürlich in der Tatsache, dass Wissenschaftler wie Kepler, Weber, Gauß oder Planck, wenn sie tatsächlich die von den Wissenschaftlern des USGS propagierten Standards angewandt hätten, keine ihrer Entdeckungen jemals hätten machen können.

![]()

Diejenigen Wissenschaftler, die auf diesem neuen Gebiet der Erdbebenvorhersage tatsächliche Entdeckungen machen wollen, die viel dazu beitragen würden, das Wissen der Menschheit über den Kosmos zu erweitern und auch zahllose Leben zu retten, wären viel besser damit bedient, ein wenig demütig zu sein, die “elastische Rückprall”-Lösung wieder auszuspucken und wie Kepler, Gauß, Planck und Frank Hoogerbeets zu denken.

![]()

Autor: Matthew Ehret

![]()

Am 11.02.23 erschienen auf: https://www.thelastamericanvagabond.com/will-the-turkish-earthquake-unleash-science-from-the-shackles-of-the-statisticians/

![]()

Spendier mir 'nen Kaffee

Spendier mir 'nen Kaffee